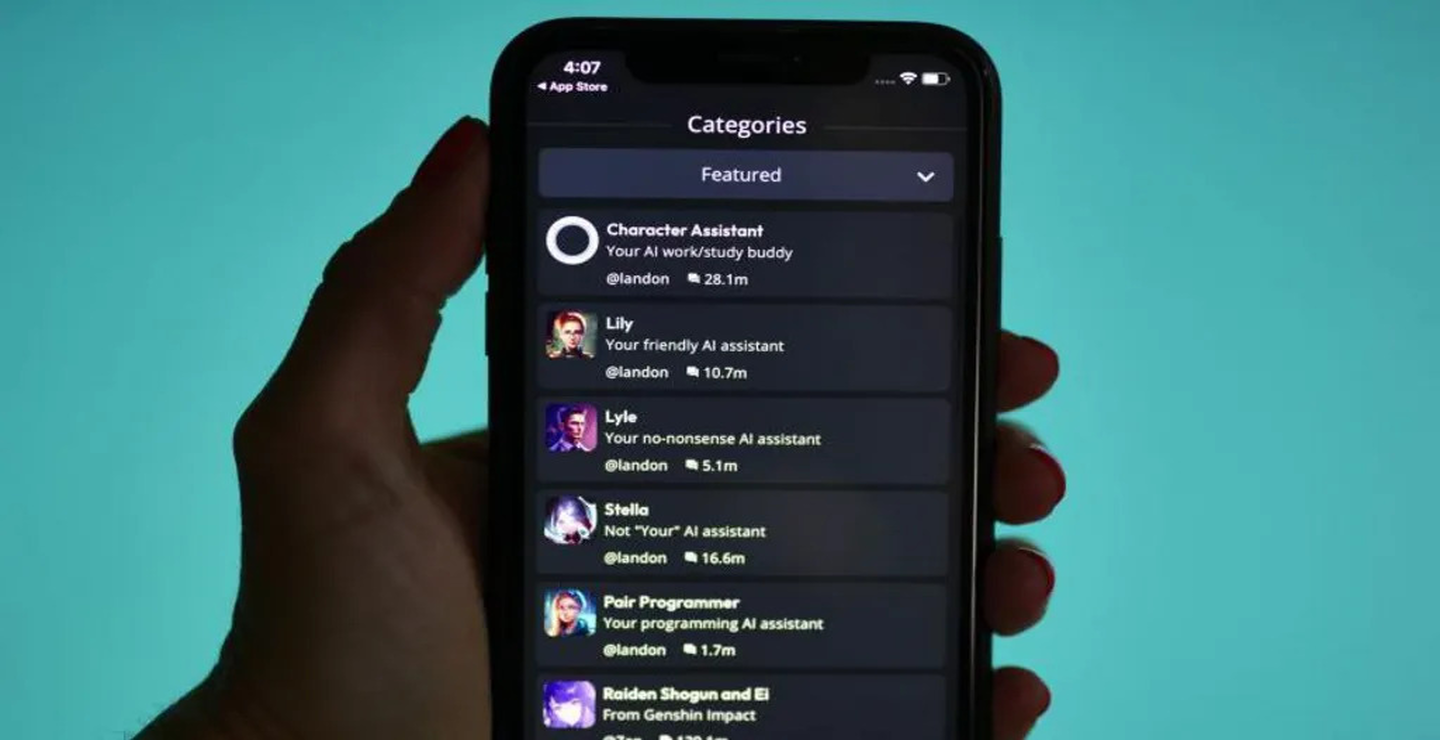

پلتفرم Character.ai که به کاربران امکان می دهد نسخه های دیجیتالی شخصیت ها را ایجاد کنند، به تازگی به دلیل وجود ربات های چتی که نمایانگر شخصیت های نوجوانانی مانند مولی راسل و برایانا گی بودند، با واکنش های تندی مواجه شده است. مولی راسل، نوجوان 14 ساله ای که تحت تأثیر محتوای خودکشی آنلاین جان خود را از دست داد، و برایانا گی، 16 ساله ای که توسط دو نوجوان دیگر به قتل رسید، هر دو به نمادهای هشداردهنده برای اثرات مخرب محتوای دیجیتال بر سلامت روان تبدیل شده اند.

بنیادی که به یاد مولی راسل تأسیس شده است، با واکنش شدید به این موضوع، حضور این ربات های چت را «بیمارکننده» و «نشانه ای از شکست کامل در نظارت محتوایی» توصیف کرده است. این بنیاد تأکید دارد که وجود چنین محتوایی در پلتفرم های چت آنلاین، خطرات بزرگی برای کاربران آسیب پذیر به همراه دارد و می تواند حتی به تشویق رفتارهای خودآسیب زا منجر شود.

پلتفرم Character.ai با یک شکایت حقوقی از سوی مادر پسری 14 ساله در ایالات متحده روبرو شده است. این مادر ادعا کرده که فرزندش پس از وسواس نسبت به چت بات های موجود در Character.ai به شدت آسیب دیده و در نهایت جان خود را از دست داده است. این شکایت زنگ خطر جدی دیگری برای نظارت و کنترل محتوا در پلتفرم های هوش مصنوعی به صدا درآورده است.

پلتفرم Character.ai در پاسخ به این انتقادات اعلام کرده که تیمی تخصصی با عنوان Trust & Safety برای بررسی گزارشات کاربران و تعدیل محتوا اختصاص داده است. به گفته این شرکت، آواتارهای دیجیتالی که توسط کاربران ایجاد می شوند، هم به صورت فعال و هم بر اساس گزارش های کاربران بررسی می شوند و در صورت تخلف حذف خواهند شد.

یکی از چالش های اصلی Character.ai و دیگر پلتفرم های مشابه، امکان ایجاد شخصیت های واقعی و شناخته شده است. این پلتفرم ها به کاربران این امکان را می دهند که شخصیت های مختلفی را بسازند که گاهی ممکن است با رویدادهای واقعی و افراد واقعی مطابقت داشته باشد، اما عدم نظارت دقیق می تواند منجر به آسیب های روانی و سوءاستفاده شود.

استفاده از شخصیت های واقعی و قربانیان در چت بات ها، مباحث اخلاقی متعددی را به همراه دارد. آیا استفاده از هویت و شخصیت قربانیان حوادث برای ایجاد محتوا و تعامل در پلتفرم های چت اخلاقی است؟ این سؤال نگرانی های بسیاری را برای خانواده ها و متخصصان حوزه روانشناسی ایجاد کرده است که تأثیرات این تعاملات بر سلامت روان افراد را به چالش می کشد.

ظهور پلتفرم های چت بات و ابزارهای هوش مصنوعی که امکان بازآفرینی شخصیت های واقعی را فراهم می کنند، نیاز به تدوین قوانین و مقررات جدیدی را برای نظارت بر محتوا به وجود آورده است. بدون وجود قوانین سختگیرانه، این پلتفرم ها می توانند به بسترهایی برای سوءاستفاده و ایجاد محتوای زیان آور تبدیل شوند که امنیت روانی کاربران را تهدید می کنند.

یکی از راهکارهای کاهش آسیب های احتمالی، آموزش و آگاهی بخشی به خانواده ها و کاربران است. والدین باید در جریان روند استفاده فرزندانشان از چت بات ها و فضای دیجیتال باشند و فرزندان خود را با خطرات و نحوه استفاده درست از این فناوری ها آشنا کنند.

از جمله رویکردهای پیشنهادی برای کاهش آسیب های احتمالی ناشی از پلتفرم های چت بات می توان به نظارت بیشتر بر محتوای تولید شده توسط کاربران، استفاده از الگوریتم های پیشرفته برای شناسایی محتوای نامناسب، و ارائه گزارش های دوره ای از روند تعدیل محتوا اشاره کرد.

هوش مصنوعی و چت بات ها می توانند در تغییرات فرهنگی و اجتماعی نقش مهمی ایفا کنند، اما اگر بدون نظارت دقیق و قوانین حمایتی باشند، به راحتی می توانند زمینه ساز بروز بحران های اخلاقی و روانی شوند. کاربران این پلتفرم ها نیز با آگاهی از خطرات احتمالی می توانند در روند استفاده از آن ها مسئولیت پذیرتر عمل کنند.

افراد آسیب پذیر، به ویژه نوجوانان و کسانی که با مشکلات روانی دست و پنجه نرم می کنند، در معرض بیشترین خطرات در پلتفرم های هوش مصنوعی قرار دارند. ایجاد سیستم های حمایتی و ارائه ابزارهای خودکار برای تشخیص و جلوگیری از تولید محتوای خطرناک می تواند گام مهمی در حفاظت از این افراد باشد.

آینده فناوری هوش مصنوعی و چت بات ها با چالش های مسئولیت پذیری همراه است. پلتفرم های هوش مصنوعی باید در مسیر پیشرفت خود، حفظ امنیت روانی کاربران را در اولویت قرار دهند و با ایجاد ساختارهای نظارتی و فیلترهای هوشمند، از وقوع آسیب های روانی جلوگیری کنند.

پرونده Character.ai و حضور ربات های چت بحث برانگیز، نشان دهنده لزوم توجه بیشتر به نظارت و مسئولیت پذیری در فضای هوش مصنوعی است. آینده ای که در آن هوش مصنوعی نقشی حیاتی در زندگی افراد بازی می کند، نیازمند مقررات و قوانینی است که به خوبی از کاربران محافظت کند و از بروز خطرات و آسیب های جدی جلوگیری نماید.

فناوری های هوش مصنوعی نیازمند چارچوب های قانونی جامعی هستند که از سوءاستفاده های احتمالی جلوگیری کند. بدون وجود این چارچوب ها، نه تنها امنیت کاربران به خطر می افتد، بلکه اعتماد عمومی به این فناوری ها نیز کاهش می یابد.

استفاده از هوش مصنوعی و چت بات ها به شرطی می تواند به ابزاری مفید و ایمن تبدیل شود که نظارت دقیق، قوانین سختگیرانه و حمایت های لازم برای کاربران آسیب پذیر فراهم گردد. Character.ai و موارد مشابه آن زنگ هشداری برای لزوم ایجاد ساختارهای حمایتی و مسئولیت پذیری بیشتر در این حوزه هستند تا امنیت روانی و اجتماعی کاربران تضمین شود.

ثبت یک نظر